KI-Blog

Artikel zu Machine Learning, LLM, Suche & Text Mining

Projektstart von TSS MoVe

10.07.2025

Das Projekt„Verkehrsübergreifendes Technologie-Scouting-System für Mobilität und Verkehr (TSS MoVe)“ strebt die Entwicklung eines innovativen Pilotsystems zur automatisierten Technologierecherche an.

KI und Datenschutz

30.06.2025

Warum jetzt der richtige Zeitpunkt ist, um Datenschutz nicht isoliert zu betrachten, sondern in Verbindung mit unternehmensweiten KI-Strategien.

Der digitale Rosetta-Stein: Universelle Semantik in Sprachmodellen

03.06.2025

Das Paper „Harnessing the Universal Geometry of Embeddings“ stellt eine einfache, aber weitreichende Idee vor: Unterschiedliche Embedding-Modelle könnten eine gemeinsame semantische Struktur teilen – und lassen sich ohne gepaarte Daten in einen gemeinsamen Raum überführen.

KI-Agenten im Peer Review: Automatisierte Forschung und ihre Grenzen

02.05.2025

KI-Agent verfasst wissenschaftlichen Forschungsbericht und besteht Peer-Review - Ist der Mensch im Erkenntnisprozess wissenschaftlicher Forschung bald ersetzbar?

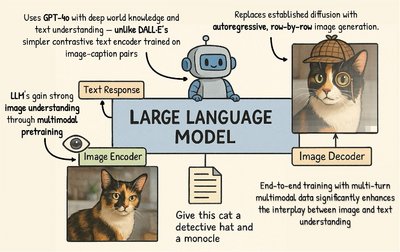

Die neue KI-Bildgenerierung von OpenAI

02.04.2025

Die neue KI-Bildgenerierung von GPT-4o hat eine große Faszination ausgelöst. Wir schauen genauer hin und zeigen die Funktionsweise und Hintergründe auf. Mehr im KI Journal Club

Wie eine bessere Suche den Support revolutioniert

28.03.2025

Lange Wartezeiten, komplizierte Prozesse oder unklare Hilfeseiten frustrieren Nutzer. Die Lösung? Ein Self-Service, der funktioniert – und als Herzstück davon eine präzise und intuitive Suche.

Generative KI richtig bewerten

13.03.2025

Welche Business-Aufgaben lassen sich mit KI-Agenten und generativer KI automatisieren? Eine Bewertungsgrundlage für KI-Anwendungsfälle in Unternehmen.

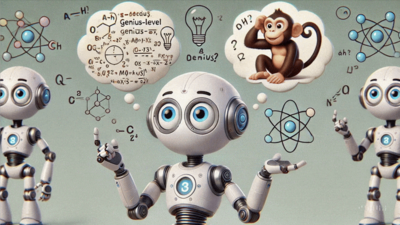

Reasoning-Modelle

28.02.2025

Ob Grok-3 Think, DeepSeek R1 oder OpenAI o3 – die neuesten Entwicklungen in der KI-Welt zeigen, dass Reasoning-Modelle zunehmend in den Fokus rücken. ontolux klärt auf.

10 Tipps, für eine erfolgreiche Suche im E-Commerce

02.04.2025

Eine schlechte Suchfunktion frustriert Nutzer und führt zu Umsatzverlusten, während eine optimierte Produktsuche Conversions steigert und die Kundenzufriedenheit verbessert.

Werden Sprachmodelle immer dümmer?

02.04.2025

Nutzer berichten, dass sie den Eindruck haben, dass die Qualität der Sprachmodelle sinken würde. Erfahren Sie, warum es sich um eine Fehlwahrnehmung handelt.

Suchqualität im E-Commerce: Der geheime Hebel für mehr Umsatz

02.04.2025

Erfahren Sie, wie die Optimierung der Produktsuche im E-Commerce Conversion-Raten steigert und Null-Treffer-Suchen reduziert – inkl. praktischer Tipps und Tools.

KI-Modell o3 von OpenAI und der ARC-AGI-Benchmark

02.04.2025

Das neue KI-Modell o3 von OpenAI hat einen ARC-ARI Benchmark von 87,5% erreicht. Was ARC-AGI ist und wie der Durchbruch von o3 neue Horizonte für die KI-Forschung eröffnet.

LLM Hosting - cloud, on-premise oder hybrid?

02.04.2025

In unserem Whitepaper „LLM Hosting" erfahren Sie, welche LLM-Hosting-Optionen es gibt und welchen Einfluss das auf Kosten, Datenschutz und Leistung hat.

KI-Sprachmodelle: Live- vs. zyklische Anwendungen

02.04.2025

KI-Anwendungen lassen sich in Live- und zyklischen Anwendungen unterscheiden. Wir beleuchten Vor- und Nachteile, zeigen Praxisbeispiele und geben Empfehlungen zur optimalen Implementierung.

Strukturierter Output und strukturierte Generierung

02.04.2025

Wie stellt man sicher, dass der Output eines Sprachmodells so strukturiert ist, dass andere Systeme ihn zuverlässig verarbeiten können? Wir stellen zwei Ansätze vor.

KI-Hardware: Was für den Betrieb von Künstlicher Intelligenz nötig ist

02.04.2025

Ein KI-System erfordert, ähnlich wie in der Weihnachtsvorbereitung, eine abgestimmte Zusammenarbeit verschiedener KI-Hardware-Komponenten. Wir stellen sie vor.

Nvidia Minitron: LLMs verkleinern und Kosten sparen

02.04.2025

Minitron ermöglicht Sprachmodelle effektiv zu verkleinern, wodurch LLM-Anwendungen kostengünstig & ressourcenschonend auch lokal betrieben werden können.

Multimodale LLMs: Wenn LLMs sehen und hören lernen

07.10.2024

Moderne KI-Modelle wie GPT-4o können zunehmend multimodal arbeiten und Text aber auch Bilder, Videos und Audios verarbeiten. Mehr im KI Journal Club

LLMs im Vergleich

23.09.2024

In unserem Whitepaper „Sprachmodelle im Vergleich: Open Source vs. Proprietäre Lösungen" nehmen wir führende Large Language Models genau unter die Lupe.

Speculative Decoding

05.09.2024

Speculative Decoding bietet einen neuen Ansatz, um die Effizienz der Textgenerierung zu verbessern, ohne die Qualität zu beeinträchtigen. Mehr erfahren

ontolux stellt KI-Sprachmodelle bei medianet KI-Sprechstunde vor

27.08.2024

Im Rahmen der medianet KI-Sprechstunde stellt Bertram Sändig, COO der KI-Agentur ontolux verschiedene Large Language Modelle gegenüber.

Künstliche Intelligenz und Ethik

24.07.2024

In diesem Artikel stellen wir aktuelle ethische Überlegungen zu KI vor und gehen dabei auf einzelne Gesellschaftsbereiche ein.

Optimierung von RAG-Systemen durch Selbstreflexion

26.06.2024

Retrieval Augmented Generation Systeme erweitern große Sprachmodelle (LLM) durch die Einbindung externer Datenquellen. Sie rufen relevante Dokumente ab, um kontextbasierte Antworten zu liefern. Wir zeigen Ansätze zur Optimierung dieser Systeme.

Der European AI-Act und die Folgen für Unternehmen

11.06.2024

Die Arbeit mit künstlicher Intelligenz erfordert den Schutz der Grundrechte. Wir informieren über die Hintergründe und Folgen der europäischen KI-Verordnung.

Mit Kahneman-Tversky-Optimization Chatbots verbessern

31.05.2024

Kahneman-Tversky-Optimization ist eine neue Möglichkeit, die Qualität von Chatbot-Antworten zu optimieren. Was macht diesen Ansatz im Vergleich zu seinen Vorgängern RLHF und DPO so besonders?

Retrieval Augmented Generation für Fortgeschrittene - LLM Kontextfenster

30.04.2024

Das Erzeugen von falschen oder irreführenden Informationen der Large Language Models ist durch die Erweiterung von Kontextfenster minimierbar. Wir erklären wie.

Wie gut sind Sprachmodelle im Deutschen?

09.04.2024

Wie gut funktionieren Sprachmodelle für die deutsche Sprache, wenn die meisten Modelle mit englischen Texten trainiert und bewertet werden? ontolux hat es getestet.

Learning to rank: Mit Machine Learning zu besseren Suchergebnissen

15.03.2024

Wie bei einem deutschen Versicherer die interne Suche durch ein Learning to Rank Verfahren in Apache Solr verbessert wurde - eine Praxisanleitung.

Large Language Models verbessern sich selbst

28.02.2024

In unserer aktuellen Ausgabe des KI Journal Clubs stellen wir eine Untersuchung zum Thema Self-Rewarding Language Models vor.

Grundsätze zur Verbesserung von Prompts

29.01.2024

Am Thema Prompt Engineering kommt man im Machine Learning momentan nicht vorbei. Gut also, dass nun erste Schritte in Richtung einer Systematisierung des Verfahrens gegangen werden.

Längere Kontexte und externes Wissen mit LLMs

04.12.2023

Tagtäglich werden Neuigkeiten zu den Themen KI, Machine Learning und Language Modeling publiziert. Heute wirft unser KI-Journal Club einen Blick auf drei Dokumente aus dem LLM-Bereich.

ontolux auf der BMBF-Mittelstandskonferenz in Berlin

08.11.2023

Auf der BMBF-Mittelstandskonferenz stellt Neofonie mit ihrer KI-Agentur ontolux die beiden Forschungsprojekte „Tech2Text“ und „AI4SCM“ vor.

Global TechMining Conference: Vorstellung des Forschungsprojekts "Text2Tech"

30.10.2023

Jan-Tilmann Seipp von ontolux stellt gemeinsam mit David Harbecke (DFKI) und Felix Köhler (inpro) Ergebnisse vom kollaborativen Forschungsprojekt „Text2Tech“ vor.

Warum wir Prompt-Engineering noch brauchen

24.11.2023

Wie viel technisches Feingefühl ist in Zeiten von ChatGPT eigentlich noch notwendig, um LLMs sinnvoll nutzbar zu machen oder wozu braucht es Promt-Engineering?

LLM Llama 2 von Meta

29.08.2023

Ende Juli 2023 wurde der neuer Player Llama 2, ein LLM von Meta, vorgestellt. Doch wie hält es sich im Vergleich zu seinen Vorgängern? ontolux reviewt das Modell

Neofonie erhält Deep Tech Award 2023

06.07.2023

Neofonie erhält Deep Tech Award 2023 in der Kategorie IT-Security von der Berliner Senatsverwaltung für Wirtschaft, Energie und Betriebe. Bei dem eingereichten Projekt kommt TXTWerk zur Anwendung.

Aufbau einer intelligenten Suche

06.06.2023

Welche Schwachstellen weisen Standard-Suchen auf und wie können diese identifiziert und optimiert werden? Cornelia Werk, Search Consultant, gibt Antworten.

ontolux bei der Mind Mastering Machines 2023

26.04.2023

Auf der M3 Konferenz stellt Bertram Sändig von ontolux am 11.05.23 in seinem Vortrag domänenspezifische Ontologien in der IT-Sicherheitsbranche im Bereich ML vor.

Neues Forschungsprojekt: AI4SCM

31.03.2023

Das Forschungsprojekt AI4SCM hat zum Ziel, Methoden für die Beobachtung und Erkennung von Supply Chain Risiken zu entwickeln.

Deep Learning - Funktionen und Anwendungsbeispiele

15.03.2023

AlphaGo und DeepFace haben Deep Learning bekannt gemacht. Was sind die Möglichkeiten? Wir geben einen Überblick über Deep Learning und Machine Learning.

AI-Tools auf dem Prüfstand

30.11.2022

Die aktuelle Ausgabe vom KI-Journal Club stellt AI-Tools auf den Prüfstand. Gerade mit Blick auf korrekte Ergebnisse, ist Kritik gegenüber der AI angebracht.

Autonomes Fahren auf dem Rückzug

31.10.2022

Dr. Till Plumbaum berichtet u.a. über den Rückzug von Ford und VM vom autonomen Fahren sowie von Bias, Vorurteilen und den Grenzen von KI.

Was ist Natural Language Processing?

10.10.2022

Was bedeutet Natural Language Processing (NLP), welche Funktionen und Anwendungen sind damit möglich. Eine Begriffserläuterung.

KI Made in Germany

30.09.2022

In der September-Ausgabe unseres Newsletters gehen wir der Frage nach, wie weit ist der Entwicklungsstand von KI "Made in Germany".

Wie gefährlich ist KI?

31.08.2022

In der aktuellen Ausgabe unseres Newsletters gehen wir der Frage nach, wie gefährlich ist KI eigentlich und was gegen Deepfakes getan wird.

Rückblick - ontolux Vorträge bei der M3 und der Berlin Buzzwords

18.07.2022

ontolux stellte Methoden für ressourcensparende KI-Modelle bei der Minds Mastering Machines und Berlin Buzzwords im Juni 2022 vor.

NLP Summer School

29.07.2022

Die Juli-Ausgabe von unseres Newsletters nutzt die Sommerzeit für ein paar Tipps zur Beschäftigung mit dem Thema Natural Language Processing.

ontolux bei der Berlin Buzzwords 2023

13.06.2022

Buzzwords: Qi Wu, Bertram Sändig von ontolux stellen am 19.06.23 in ihrem Vortrag domänenspezifische Ontologien in der IT-Sicherheitsbranche im Bereich ML vor.

Emotionen und Language Models

30.06.2022

Die Juni-Ausgabe des Newsletters von ontolux thematisiert in kritischer Form Language Models und Emotionen. Überflügelt KI den Menschen?

Kickoff des dreijährigen Forschungsprojekts Text2Tech

27.06.2022

Gemeinsam mit den Verbundpartnern inpro, DFKI und Neofonie mit seiner Marke ontolux und dem Projektträger DLR wurde das vom Bundesministerium für Bildung und Forschung geförderte Verbundsforschungsprojekt Text2Tech gestartet.

KI in der Justiz

30.05.2022

In der Mai-Ausgabe unseres Newsletters wird der Einsatz von KI in der Justiz diskutiert. Weitere Themen sind Googles T5 Update und die Annäherung von Elastic und AWS.

Die neuen ML-Modelle DALL-E 2 und PaLM

29.04.2022

Was bringen die neuen Machine Learning-Modelle DALL-E 2 von OpenAI und PaLM von Google? Und gehen GPT-3 und T5 damit langsam in Rente?

Entity Linking mit Doccano und TXTWerk (ontolux Fork)

22.04.2022

Zum Labeling von Entitäten hat ontolux das Annotationstool Doccano an das hauseigene Textanalyse-Framework TXTWerk eingebunden.

Bias und KI

31.03.2022

In der März-Ausgabe geht es um Themen wie Bias, Predictive Policing, Accountability bei den Weight Watchers und um Lieferkettenprobleme.

Language Models und Ethik

28.02.2022

Während die Arbeit an GPT-X als europäische Antwort auf GPT-3 startet, konzentriert sich ein Forschungsteil auf Ethik und Bias Themen.

Natural Language Processing mit dem Wikidata Knowledge Graph

28.02.2022

Erfahrungen, beim Natural Language Processing mit dem Wikidata Knowledge Graph stellt ontolux auf den Wikidata Data Reuse Days 2022 vor.

ontolux bei der Mind Mastering Machines 2022

28.02.2022

ontolux stellt Methoden zur Ressourceneinsparung von KI-Modellen mittels Knowledge Destillation auf der M3 2022 vor.

ChatGPT im Realitätscheck

23.02.2022

Wie funktioniert der Cahtbot ChatGPT und welchen Nutzen bietet er Unternehmen? ontolux stellt sich diesen Fragen und zeigt Chancen und Grenzen auf.

Zur Bedeutung des beutellosen Staubsaugers für die Intelligente Suche

14.02.2022

Angeblich stehen Alltagsgeräte und das Thema Intelligente Suche nicht in einem klaren inhaltlichen Zusammenhang. Ein Gegenbeispiel.

Lucence 9

31.01.2022

Mit Lucene 9 wurde jetzt die Unterstützung für die Indizierung hochdimensionaler, numerischer Vektoren eingeführt zur Optimierung der Suche.

Modellkomprimierung: Methoden zur Ressourceneinsparung von KI-Modellen

17.01.2022

Um die Rechenkosten von KI-Modellen und die daraus entstehenden Umweltbelastungen zu reduzieren, stellt Qi Wu Lösungsoptionen vor.

Question Answering bei Language Modellen

30.12.2021

Das Jahr wurde geprägt von Language Modellen, aber generell war eine gewisse Stagnation im Bereich KI und NLP zu erkennen. Mehr erfahren

Neuronale Netze für NLP

07.12.2021

Im ontolux Blog stellen wir bekannte, neuronale Netze für NLP hinsichtlich ihrer Leistung, Größe und Energieeffizienz vor.

Fortschritte in der KI

30.11.2021

Wie ist der aktuelle Stand von KI und welche Einflüsse haben die Entwicklungen in der Informatik, Mathematik und Computertechnik?

Deutschsprachige NLP Frameworks unter der Lupe

19.11.2021

Welche NLP-Frameworks gibt es und welches eignet sich wofür? ontolux hat die wichtigsten Anbieter für deutschsprachige Texte getestet.

MICES 2021: Warum eine goldstandard-basierte Evaluation?

29.01.2024

Vortrag auf der MICES: “Weil Vorbeugen besser als Heilen ist: goldstandard-basierte Evaluation in Kundenprojekten” für eine optimierte Suche.

Neues Language Modell MT-NLG

31.10.2021

Die aktuelle Oktoberausgabe vom KI-Journal Club stellen wir u.a. das neu erschienene Language Model - MT-NLG von Microsoft und NVIDIA vor.

Idee der Foundation Models

30.09.2021

Rund 100 Forscher haben die Idee der Foundation Models eingeführt, welche die Grundlage für viele aufgabenspezifische Modelle legen soll.

Weil Vorbeugen besser als Heilen ist: Goldstandard für kundenspezifische Suchlösungen

14.09.2021

In unserem kostenfreien Whitepaper stellen wir Konzepte und Beispiele einer goldstandardbasierten Optimierung von Suchlösungen vor.

Neues Forschungsprojekt: Semantische Begriffsanalyse für Information Retrieval Aufgaben (SEBIRA)

27.08.2021

ontolux beteiligt sich am neuen ZIM-Forschungsprojekt zur semantischen Begriffsanalyse für Information Retrieval Aufgaben (SEBIRA).

Hype um große Sprachmodelle

30.07.2021

Sprachmodelle wie GPT-3, Wu Dao 2.0 oder MUM werden auf immer größer und auf zahlreichen Daten trainiert. Doch ist immer größer immer besser?

Unnatürliche Sprachinferenz

30.07.2021

Auf der ACL Konferenz wurde u.a. untersucht ob NLP Modelle die Syntax der menschlichen Sprache gelernt haben und schauen uns ein paar Beispiele an, wie schnell KI-Anwendungen in produktiven Einsatz genommen werden und dessen Folgen.

EM 2020: Fußball für alle

28.07.2021

EM 2020 - ontolux analysiert Social Media und stellt Spieltaganalysen auf Basis von Entitäten-Erkennung & Sentiment-Analyse vor.

Google und KI

30.06.2021

Auf der Google I/O Konferenz kündigt Google ein neues Konversations-Sprachmodell an und ihre Arbeiten an der Umwandlung von Wissensgraphen.

EU Regelwerk für KI

31.05.2021

Mit dem EU Regelwerk für KI sollen die Grundrechte und Werte der EU innerhalb der KI-Entwicklung sichergestellt werden.

KI im deutschen Mittelstand

30.04.2021

KI im Deutschen Mittelstand zeigt noch Schwächen, dabei gelingt es bereits mittels Computermodelle Sprache zu verarbeiten.

Mit Trivy mehr Sicherheit für TXTWerk

05.03.2021

Um die Sicherheit der Text Mining Software TXTWerk dauerhaft zu gewährleisten, hat ontolux den Vulnerability Scanner Trivy in die Continuous Integration/Continuous Delivery Pipeline integriert.

TXTWerk hat Recht

26.02.2021

TXTWerk kann Texte mit rechtlichen Referenzen analysieren und so referenzierte Paragrafen erkennen und in strukturierte Form bringen.

Selbstlernende Chatbots programmieren

27.01.2021

Wie programmiert man einen selbstlernenden Chatbot in wenigen Schritten? Vorteile sind vereinfachte Dialogprozesse für Unternehmen.

Kategoriefilter