Die Flut an neuen Large Language Models (LLMs) rollt weiter. GPT-4 steht vor der Tür (vielleicht). Mit Bloom wurde ein neues großes Open Source LLM freigegeben, das z.B. für Studien der internen Abläufe in den LLMs genutzt werden soll und kann. Facebook AI Research (FAIR) hat ebenfalls ein neues LLM vorgestellt, Galactica, das entwickelt wurde, um wissenschaftliche Forschungsarbeiten und Wikipedia-Artikel zu schreiben. An diesem Modell entbrannte dann auch eine große Diskussion über die Gefahr eines solchen Modells, das einfach viele Fehler produziert für die Wissenschaft. So besteht die Gefahr, dass das Modell es ermöglicht, Paper mit falschen Fakten schnell zu publizieren und damit die wissenschaftliche Welt zum Einsturz zu bringen. FAIR hat daraufhin relativ schnell das Modell wieder zurückgezogen, um auch die Diskussion nicht weiter zu befeuern. Die Angst, durch ein Modell wie Galactica den wissenschaftlichen Prozess des Peer Reviews zum Erliegen zu bringen, ist übertrieben. Auch das Wissen, das LLMs Fehler einbauen ist nicht neu, umso mehr überraschte die heftige Diskussion zu dem Modell. Die Frage ist und bleibt, wie kann man gegen diese Probleme vorgehen und hilft es, immer neue Modelle zu trainieren? Wäre man vielleicht weiter, wenn man die LM-Fähigkeiten vor zwei Jahren auf dem GPT-3-Niveau eingefroren hätte und nur an Fine-Tuning, Prompt-Engineering, Neugestaltung der Aufgaben, neue Benutzeroberflächen gearbeitet und geforscht hätte?

Die Werkzeuge, die wir nutzen…

Nicht nur bei den Sprachmodellen muss man aufpassen, auch “klassische” Software kann so manchen kritischen Nebeneffekt haben. So haben zwei Autoren der Universität Warwick und der Harvard Business School untersucht, wie sich ein „technisches Problem“ auswirkte, das in der Nacht vom 2. auf den 3. Oktober 2020 von den Gesundheitsbehörden in England bei der Ermittlung von Covid-Kontaktpersonen entdeckt wurde. In einer internen Untersuchung wurde festgestellt, dass sowohl in den offiziell gemeldeten Zahlen als auch in den Falldaten, die an das nationale System zur Ermittlung von Kontaktpersonen übermittelt wurden, insgesamt 15.841 positive Fälle versehentlich übersehen worden waren – etwa 20 Prozent aller Fälle in dieser Zeit. Dieser Fehler war darauf zurückzuführen, dass Fallinformationen versehentlich aus Excel-Tabellen abgeschnitten wurden, nachdem eine Zeilengrenze erreicht worden war.

Die Forscher kommen zu dem Schluss, dass auch bei einer vorsichtigen Schätzung der kausalen Folgen, dieser Fehler zu zwischen 1,521 und 2,049 zusätzlichen Toten geführt hat.

Stable Diffusion Version 2

Stability AI hat Version 2 ihres Text2Bild Generators Stable Diffusion veröffentlicht. Darin enthalten sind einige Verbesserungen wie ein robusterer Text2Bild Algorithmus basierend auf CLIP, der auch Bilder in einer höheren Auflösung generieren kann. Es ist auch möglich, Bilder in einer geringeren Auflösung in eine höhere Auflösung zu überführen. Neu ist auch ein Depth-to-Image Diffusion Model, das es erlaubt, ein Bild mit Tiefeninformation als Input zu nutzen und dann diese Struktur beim Generieren neuer Bilder beizubehalten.

Eine Änderung verärgert Nutzer der 2. Version von Stable Diffusion. In Version 2 hat Stable Diffusion einen Filter, der die Fähigkeit, NSFW-Ausgaben und Bilder im Stil bestimmter Künstler zu erzeugen, stark abgeschwächt hat.

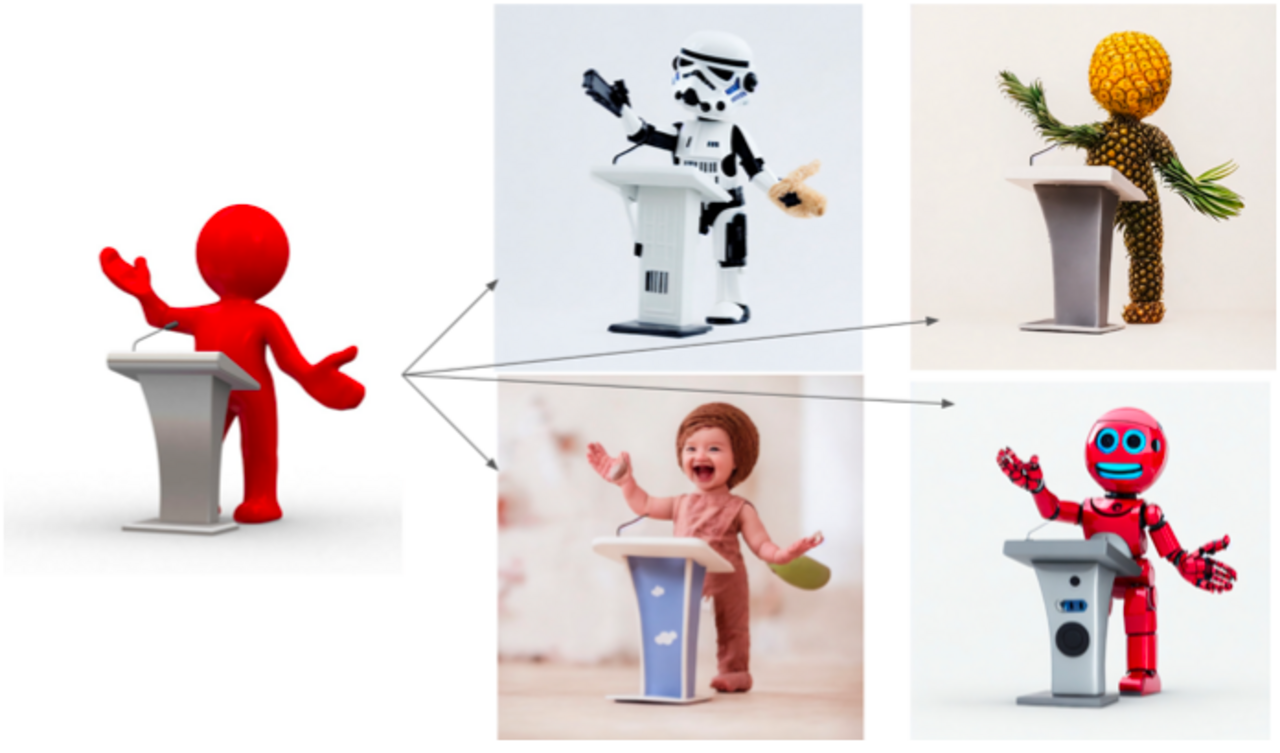

"AI in the Loop: Humans in Charge?"

Wer noch eine Alternative zum Fußball sucht, dem sei die StanfordHAI Herbst Konferenz Conference “AI in the Loop: Humans in Charge?” empfohlen. Verfügbar sind die Vorträge, unter anderem zum Thema “Designing for AI” oder auch “AI for Communities and Organizations” jetzt hier.

In unserer monatlichen Serie “KI-Journal Club” stellen wir wissenschaftliche Beiträge und Presseberichte vor aus den Bereichen Text Mining, Machine Learning, KI, Natural Language Processing.

Datum: 30.11.2022

Kontaktieren Sie uns

Einstiegsangebot für Unternehmen

Entdecken Sie die Möglichkeiten der künstlichen Intelligenz für Ihr Unternehmen. Kontaktieren Sie uns für eine kostenlose Beratung und entdecken Sie die Vorteile von Sprachmodellen, Machine Learning und Suchtechnologien.